隨著人工智能技術(shù)的快速發(fā)展,AI技術(shù)架構(gòu)已成為推動(dòng)各行各業(yè)智能化轉(zhuǎn)型的核心引擎。一個(gè)完整的AI技術(shù)架構(gòu)通常涵蓋數(shù)據(jù)準(zhǔn)備、模型開發(fā)、部署運(yùn)行和應(yīng)用集成等多個(gè)環(huán)節(jié),而軟件開發(fā)及運(yùn)行平臺(tái)服務(wù)則在這一過程中發(fā)揮著關(guān)鍵作用。本文將從模型構(gòu)建到實(shí)際應(yīng)用,全面解析AI技術(shù)架構(gòu)的組成及其在軟件平臺(tái)服務(wù)中的實(shí)現(xiàn)。

一、AI模型構(gòu)建:從數(shù)據(jù)到算法

AI模型的構(gòu)建是技術(shù)架構(gòu)的起點(diǎn)。數(shù)據(jù)采集與預(yù)處理環(huán)節(jié)為模型訓(xùn)練提供高質(zhì)量輸入,包括數(shù)據(jù)清洗、標(biāo)注和增強(qiáng)等步驟。選擇合適的算法模型(如深度學(xué)習(xí)、機(jī)器學(xué)習(xí)模型)進(jìn)行訓(xùn)練,通過優(yōu)化損失函數(shù)和參數(shù)調(diào)整,提升模型的準(zhǔn)確性和泛化能力。模型評(píng)估與驗(yàn)證確保其在實(shí)際場景中的可靠性。

二、模型部署與推理:面向應(yīng)用的技術(shù)實(shí)現(xiàn)

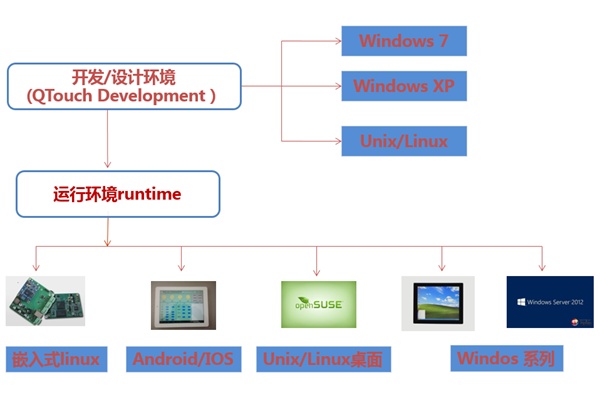

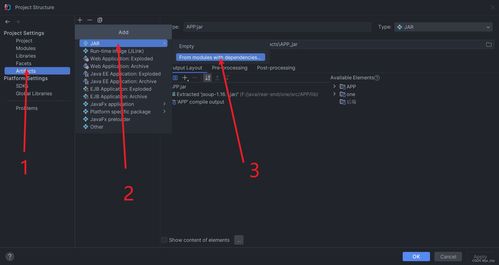

模型部署是將訓(xùn)練好的AI模型轉(zhuǎn)化為實(shí)際應(yīng)用的關(guān)鍵步驟。這包括模型壓縮、加速和容器化技術(shù),以適應(yīng)不同硬件環(huán)境(如云端、邊緣設(shè)備)。推理引擎(如TensorFlow Serving、ONNX Runtime)負(fù)責(zé)高效執(zhí)行模型預(yù)測,確保低延遲和高吞吐量。A/B測試和版本管理幫助優(yōu)化模型性能,實(shí)現(xiàn)平滑升級(jí)。

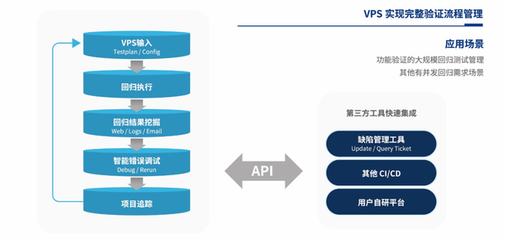

三、軟件開發(fā)及運(yùn)行平臺(tái)服務(wù):支撐AI全生命周期

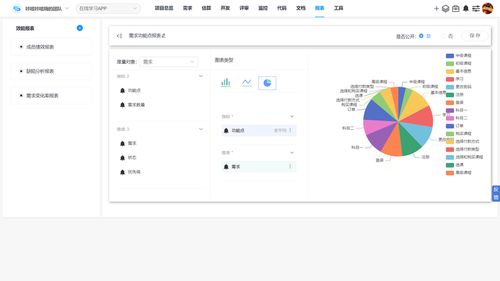

為了簡化AI開發(fā)流程,眾多平臺(tái)服務(wù)應(yīng)運(yùn)而生。這些平臺(tái)通常提供一站式解決方案,涵蓋數(shù)據(jù)管理、模型訓(xùn)練、部署監(jiān)控等環(huán)節(jié)。例如,AWS SageMaker、Google AI Platform和Azure Machine Learning等云服務(wù)平臺(tái),支持從數(shù)據(jù)預(yù)處理到模型服務(wù)的全流程自動(dòng)化。開源框架如PyTorch和TensorFlow與這些平臺(tái)深度集成,加速AI應(yīng)用的開發(fā)與迭代。

在運(yùn)行層面,平臺(tái)服務(wù)通過彈性計(jì)算、自動(dòng)擴(kuò)縮容和負(fù)載均衡,確保AI應(yīng)用的高可用性和可擴(kuò)展性。監(jiān)控與日志分析工具則幫助開發(fā)者實(shí)時(shí)跟蹤模型性能,及時(shí)發(fā)現(xiàn)并修復(fù)問題,從而降低運(yùn)維成本。

四、應(yīng)用集成與未來展望

AI技術(shù)架構(gòu)的最終目標(biāo)是賦能實(shí)際應(yīng)用,如智能客服、自動(dòng)駕駛和醫(yī)療診斷等。通過API網(wǎng)關(guān)、微服務(wù)架構(gòu),AI模型可以無縫集成到現(xiàn)有系統(tǒng)中,提升業(yè)務(wù)效率。隨著邊緣計(jì)算、聯(lián)邦學(xué)習(xí)等技術(shù)的發(fā)展,AI架構(gòu)將更加分布式和隱私保護(hù),而平臺(tái)服務(wù)也將持續(xù)演進(jìn),支持更復(fù)雜的多模態(tài)AI場景。

AI技術(shù)架構(gòu)是一個(gè)從模型到應(yīng)用的系統(tǒng)工程,而軟件開發(fā)及運(yùn)行平臺(tái)服務(wù)為其提供了強(qiáng)大的基礎(chǔ)設(shè)施。通過深入理解架構(gòu)各環(huán)節(jié),企業(yè)和開發(fā)者能夠更高效地構(gòu)建智能應(yīng)用,推動(dòng)AI技術(shù)的普及與創(chuàng)新。